Hauptmerkmal sozialer Roboter ist die Fähigkeit soziale Signale von Menschen zu verstehen und auf natürliche Weise darauf reagieren zu können. Soziale Roboter verfügen über ein größeres Potential an emotionaler und sozialer Bindung und kommen so einem natürlichen, menschlichen Umgang näher als es klassische Web- und Smartphone-Anwendungen, aber auch Staubsaugerroboter oder roboterisierte Rasenmäher können. Da Roboter zunehmend für normale Haushalte erschwinglich werden und immer mehr nützliche, gratis verfügbare Open-Source-Software im Internet existiert, sind komplexe Roboteranwendungen auch für den Normalverbraucher endlich zum Greifen nahe.

Getrieben wird diese Entwicklung von Technologien wie bspw. Sprachsynthese, Gesichts- und Stimmerkennung, Erkennung von menschlichen Gesten, Augenkontakt oder Körperbewegungen, Kamera zur Beobachtung der Umgebung, Entwicklungen in der künstlichen Intelligenz und verstärkte Aufnahme biometrischer Daten über Fitnessuhren.

Leistbare soziale Roboter unter 2500 Euro

Der Markt boomt wie nie zuvor. Niedrigpreisige Roboter für den Alltagsgebrauch sind Neuland, haben aber großes Potenzial unser Leben nachhaltig zu verbessern. Folgende Kriterien sind dabei als Mindestanforderung für die Integrierbarkeit in den Alltag wichtig:

- Mindestausstattung: Kamera, Sprachmodul

- Preis max. 2.500 Euro (idealerweise unter 1000 Euro)

- Verfügbarkeit am Markt

- Entwickler-Schnittstelle verfügbar (Software Development Kit)

- Sprache: Deutsch oder Englisch (Deutsch bevorzugt)

Im Folgenden möchten wir einige besonders spannende Kandidaten hervorheben:

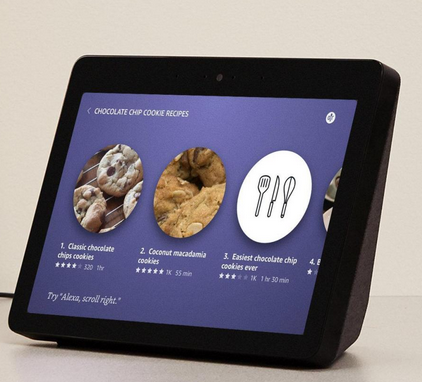

Amazon Echo Show 2

- Kosten: € 230

- Sprachen: Multilingual

- Ausstattung: Bildschirm, Kamera, Lautsprecher & Mikrophon

- Funktionen: Alle möglichen Alexa Skills z.B.: Kalender, Kochrezepte, Einschlafgeräusche, Nachrichten etc.

Oft ist es gar nicht nötig einen klassischen Roboter zu verwenden, ein Tablet reicht schon für viele Hilfestellungen aus. Sprachassistenten wie Alexa sind bereits jetzt in zahllosen Haushalten integriert. Vorhandene Alexa Skills lösen bereits viele der alltäglichen Herausforderungen für den herkömmlichen Alltag und können darüber hinaus als zentrale Stelle für die eigene Smart-Home-Steuerung verwendet werden. Doch immer mehr kritische Stimmen sehen die Abhängigkeit zu Amazon als ein Datenschutz-Problem. Echo Show 2 ist ein besonders leicht zu bedienendes und rundum gelungenes Alexa-Gerät mit hervorragender Audio-Qualität.

- Besonderheit: Besonders viele bereits verwendbare Skills decken eine breite Palette an Anforderungen ab. Skills können über Alexa-Routinen auch kombiniert verwendet werden!

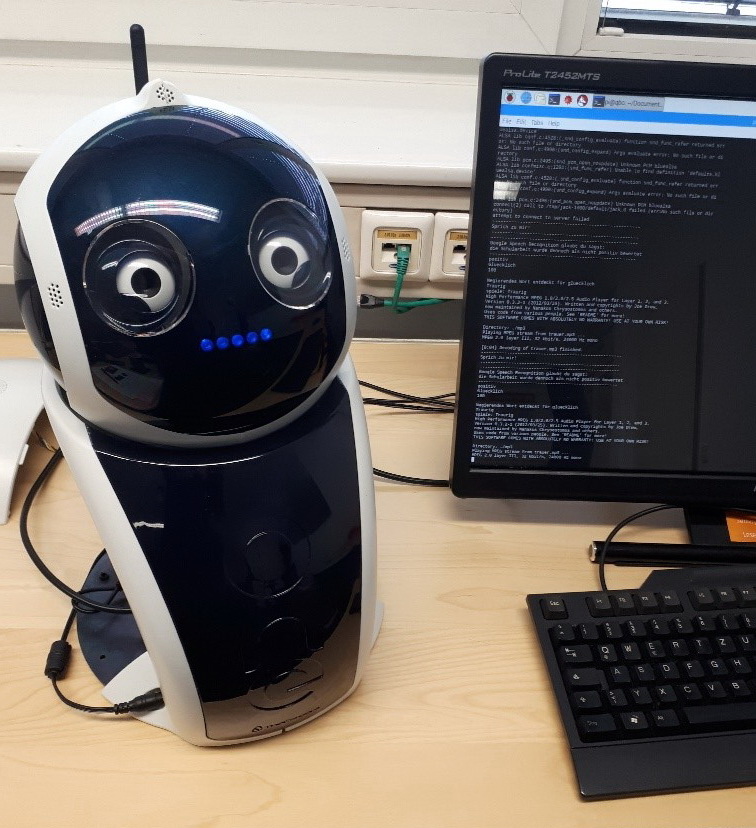

Q.bo One

- Kosten: € 449

- Sprachen: Englisch mit deutschen Updates

- Ausstattung: HDMI-Port für externen Monitor, Kamera, Lautsprecher & Mikrophon

- Funktionen: Stereoskopisches Sehen, erweiterbare Spracherkennung, System für Sprachsynthese, Web Control Panel, Wifi & Bluetooth, hat viele verschiedene Programmierschnittstellen

Q.bo One von „theCorpora“ ist eine offene Plattform für Entwickler. Er ist daher perfekt geeignet zur Weiterentwicklung und Optimierung. Intern verbaut ist ein handelsüblicher Raspberry Pi 3 und ein Arduino Board. Software-Images des Herstellers sind online zum Download bereitgestellt. Der Roboter ist vom Hardware/Software-Aufbau also so simpel, dass er in seinen Grundzügen sogar ohne gekauft zu werden problemlos nachgebaut werden könnte. Q.bo One eignet sich durch die guten Kameras gut zur Auswertung von Bildern. Deutsche Sprachausgabe muss selbstständig dazu entwickelt werden. Die Audio-Ausgabe klingt aufgrund der schwachen Lautsprecher etwas blechern.

- Besonderheit: einfach gehaltene und offene Plattform mit gutem Potential für Weiterentwicklung

Anki Vector

- Kosten: € 279

- Sprachen: derzeit nur auf Englisch

- Ausstattung: integriertes Kopf-Display, Kamera, Lautsprecher & Mikrophon

- Funktionen: Blackjack über Kopf-Display, alles was Alexa kann seit dem Update, Apportieren von mitgeliefertem Spielzeug-Würfel, Gesichtserkennung, Witze, etc.

Anki Vector ist seit seinem ersten Software-Update vollständig Alexa-kompatibel. Dieses Update und die Anmeldung bei Amazon sind optional. Die Alexa-Installation kann auf Deutsch erfolgen, der Roboter selbst ist vorerst nur auf Englisch verfügbar. Anki Vector ist gut im Erkennen von Gesichtern, leidet allerdings stark an seiner schwachen Audio-Ausgabe und dem zu kleinen Display. Besonders positiv sticht das sympathische Design und das realistische Bewegungsverhalten hervor. Auch hier zeigt sich wieder einmal, dass derzeit einfaches Roboter-Design über komplexe menschenähnliche Roboter-Gestaltungsansätze triumphiert. Leider ist Anki Vector nur teilweise weiterentwickelbar, die Idee „Roboter als niedliches Haustier“ wurde jedoch auffallend gut umgesetzt.

- Besonderheit: Roboter-Mensch-Interaktion auffallend gut gelungen mit realistischen Haustier-ähnlichen Verhaltensmustern

Dash/Dot/CUE Coding Robots

- Kosten: 200$

- Sprachen: Multilingual

- Ausstattung: Kamera, Lautsprecher & Mikrophon

- Anmerkung: Sehr gutes Preis-Leistungs-Verhältnis

Dash, Dot und CUE glänzen mit ihrer Dialogführung, Gesichtserkennung, voreinstellbaren Avataren bzw. Persönlichkeiten (Charmante Avatare mit schöner Stimme und guter Audio-Erkennung). Besonders interessant ist die Möglichkeit direkt am Handy Anweisungen und Aufgaben zu programmieren. Dies ist sowohl grafisch als auch über Javascript-Code möglich. Eignet sich sehr gut um Kinder erstmalig mit der Welt der Programmierung vertraut zu machen.

- Besonderheit: Graphisch programmierbare Aufgaben ohne Kenntnis über Programmiersprachen einfach und direkt auf dem eigenen Smartphone möglich

Tessa Robot

- Kosten: 1-Jahres-Abo: Tessa für 275 €, 3-Jähriges Abo: Tessa gratis (Software-Abo kostet 1 € pro Tag)

- Sprachen: derzeit Niederländisch und Englisch

- Ausstattung: Kamera, Lautsprecher & Mikrophon

- Funktionen: unterstützt die Tagesstruktur und gibt Anregungen für Aktivitäten. Dialogoptionen für Demenzkranke; Text und Musik – Interface

Bei der Gestaltung von Robotern spielt auch Integrierbarkeit in die eigenen vier Wände eine wichtige Rolle. Ein Paradebeispiel ist hier der in den Niederlanden entwickelte Tessa-Roboter, welcher sowohl als sozialer Roboter, als auch als Blumenstock fungiert. Es ist darüber hinaus möglich dem Roboter verschiedene Kostüme anzuziehen. Das Abo-Modell ist allerdings derzeit viel zu teuer, wenn man den Roboter auf längere Zeit verwenden möchte.

- Besonderheit: Kann als Topfpflanze getarnt nett und angenehm in einem Zimmer integriert werden, generell sehr gute Idee um einen Roboter weniger wie einen Roboter wirken zu lassen.

Maki Robot

- Kosten: kann nicht gekauft werden, wird selbst ausgedruckt

- Verfügbarkeit: Ja, die Pläne sind verfügbar

- SDK vorhanden: Noch nicht

- Sprachen: vermutlich nur Englisch

- Funktionen: Dialogführung, Gesichtserkennung, …

Schließlich möchten wir noch den Maki-Roboter vorstellen. Denn dieser Roboter kann vollständig aus einem 3D-Drucker gedruckt werden. Die ersten Pläne dafür sind bereits online auf der Herstellerseite zu finden. Wir halten die Idee einen Roboter gar nicht mehr von einem Hersteller zu kaufen, sondern selbst auszudrucken (vielleicht sogar mit einem eigenen Roboter-Design?) für sehr zukunftsorientiert. Die einzelnen Hardware-Komponenten könnten wie bereits bei Q.bo One frei zukaufbare Boards und Sensoren sein mit downloadbaren Software-Images.

- Besonderheit: Hülle kommt komplett aus dem 3D-Drucker mit frei einsehbaren Online-Plänen

Interaktionsmöglichkeiten in einem Netzwerk aus mehreren heterogenen Systemen

Da sich die Kompatibilität einzelner Roboter-Plattformen zueinander zunehmend erhöht und sich immer mehr Standards für die Kommunikation unter Robotern etablieren, werden die Interaktionsmöglichkeiten eines sozialen Roboters der Zukunft nicht nur auf die Kommunikation von Mensch-zu-Maschine beschränkt bleiben, sondern sollen den Menschen in ein Netzwerk von sich gegenseitig unterstützenden Robotern und Geräten sinnvoll einbinden. Dazu ist mindestens eine Öffnung dieser Plattformen nach außen notwendig und eine Quellcode-Transparenz der mitgelieferten Software vorteilhaft. Bevorzugt werden daher soziale Roboter, welche für externe EntwicklerInnen Möglichkeiten bereitstellen, verschiedene soziale Roboter miteinander interagieren zu lassen. Der Mensch bleibt aber auch im Szenario eines verteilten Robotersystems immer der Dreh- und Angelpunkt aller Interaktionen.

Nimmt man beispielsweise eine handelsübliche Fitnessuhr (hier FitBit Charge 2) und kombiniert ihre biometrischen Daten mit der Erkennung von Emotionen in Gesichtern (z.B. auf dem Roboter Q.bo One) und mit Alexa-Fragebogen-Dialogen, in denen das subjektive Wohlbefinden abgefragt wird, erhält man völlig neue Informationen über die aktuelle Bedürfnisse der jeweiligen Nutzerin bzw. des jeweiligen Nutzers. Dies ermöglicht eine neue Art der Personalisierung in der Roboter-Mensch-Interaktion. Das folgende Bild zeigt einen möglichen Aufbau:

In diesem Fall laufen alle Informationen auf einem „Amazon Fire Tablet 10“ zusammen. Alle Informationen werden zentral aggregiert, weiterverarbeitet und können dann beispielsweise in Form einer Android-App am Endgerät eingesehen werden

Emotionen in Gesichtern erkennen

In der Kommunikation ist es nicht nur wichtig, was gesagt wurde, sondern auch wie es gesagt wurde. In diesem Fall analysieren wir den Gesichtsausdruck einer Person bei der Interaktion mit dem Roboter.

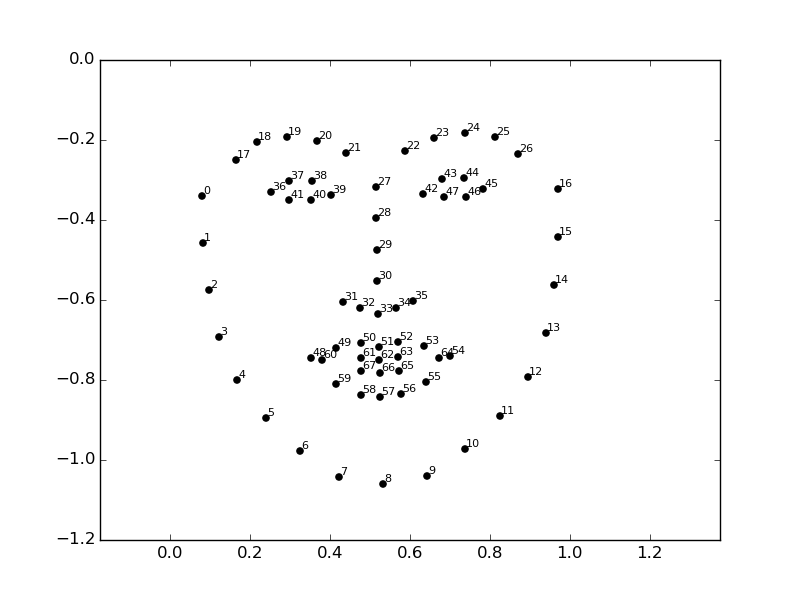

Die Gesichtserkennung basiert hier auf OpenCV und der Ekman-Methode. Sie sucht im Bild des Roboters nach einem oder mehreren Gesichtern. Gefundene Gesichter werden auf bestimmte Merkmale untersucht mit Hilfe von 68 Punkten im Gesicht und daraufhin wird der Ausdruck einem von sechs universellen Emotionen zugeordnet (Ekman, P.; Friesen, W.V. (1971): “Constants across cultures in the face and emotion”. Journal of Personality and Social Psychology. 17 (2): 124–29.).

Die erkannten 68 Punkte setzen sich zusammen aus jeweils 5 Punkten für die Augenbrauen, jeweils 6 Punkten für die Augen, 9 Punkten für die Nase, 20 Punkten für den Mund und den restlichen 17 Punkten für den Gesichtsrand um die generelle Ausrichtung des Gesichtes zur Kamera in Relation deuten zu können.

Emotionen aus gesprochenem Wort erkennen anhand des gewählten Satzbaus

Eine andere Möglichkeit, um Emotionen zu erkennen, ist die Analyse des Satzbaus einer Person bei der Interaktion mit dem Roboter.

Die Satzbau-Erkennung basiert hier wiederum auf der Ekman-Methode. Wir analysieren den Satz auf emotionale Signalwörter und deren gesprochenen Kontext. Ein paar Beispiele für Stammformen von Auslösewörter für das Gefühl „Ärger“ wären „verärger-, zorn-, wut-, wüt-, grimm-, empör-“ (und viele, viele mehr). Ein Beispielsatz könnte lauten „Ich bin stolz auf den Erfolg meiner Tochter“. Hier sind „stolz“ und „Erfolg“ typische Signalwörter für das Gefühl „Freude“.

Aber auch der Kontext des Wortes spielt eine wesentliche Rolle. Wir erhalten die gegenteilige Emotion (nämlich z.B. Trauer) wenn wir den Satz wie folgt verändern: „Ich bin nicht stolz auf den Erfolg meiner Tochter“. Wir sehen, dass Kontext bei der Analyse eines Satzes von zentraler Wichtigkeit ist. Werten wir die Ergebnisse richtig aus, können wir in Zukunft auch auf das Objekt, Subjekt und Prädikat des Satzes schließen. Kommt nun die besagte Tochter als Satzobjekt besonders häufig im Kontext von „Freude“ vor, wenn man den Nutzer/die Nutzerin frei sprechen lässt, dann hat der Roboter gelernt, dass die Tochter und der Nutzer/ der Nutzerin sich in einem positiven Verhältnis zueinander befinden. Dieses Beispiel lässt sich beliebig mit anderen erwähnten Emotionen und Satzobjekten und Satzsubjekten wiederholen.

Alexa-Dialoge sinnvoll verwenden

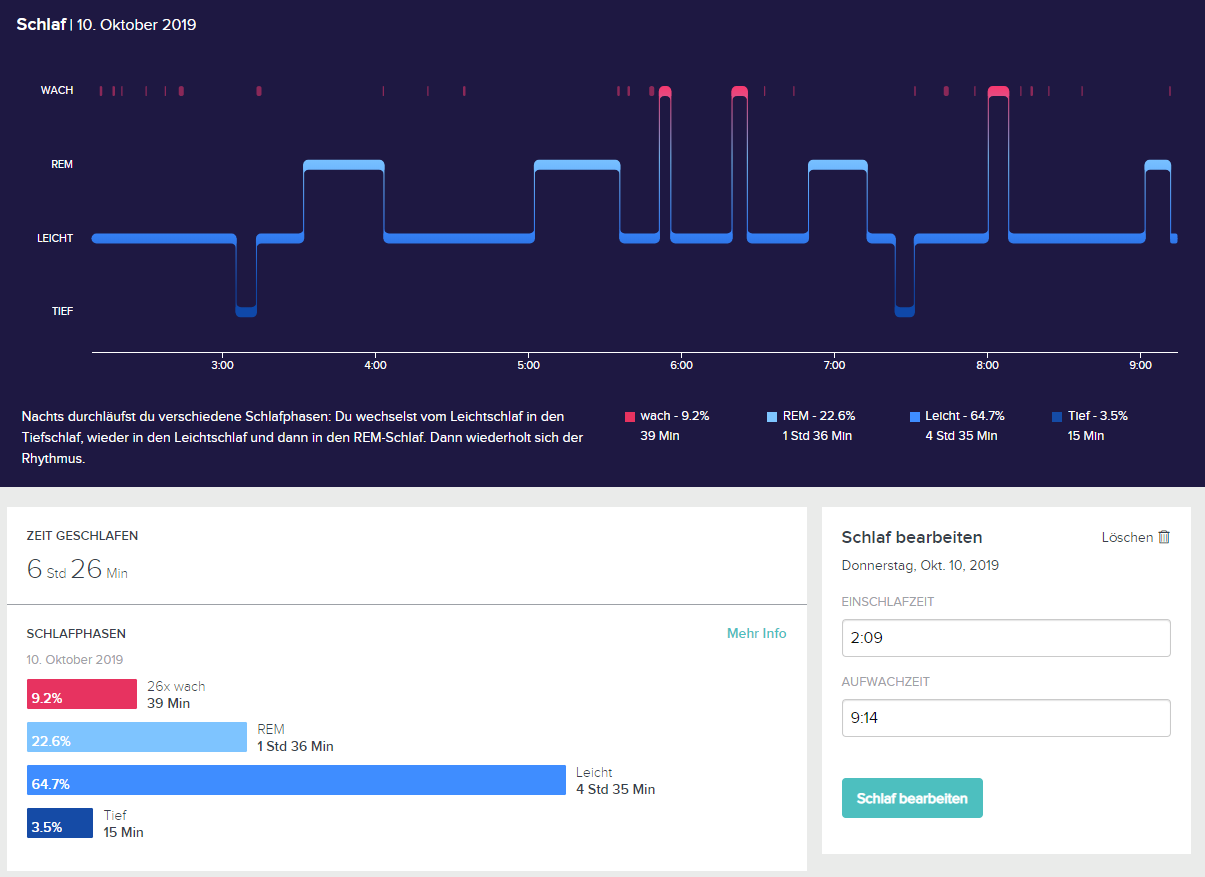

Indem man Dialoge anbietet zu Themen wie Sport, Stress oder Schlaf lernt man das subjektive Befinden einer Person im Kontext anderer Informationen kennen. Schlechte Schlaf-Daten der FitBit-Uhr könnten beispielsweise einen solchen Schlaf-Dialog auf Alexa starten (wahlweise auf einem Roboter oder auf einem Alexa-Tablet). Hier sehen wir eine schlechte Schlafkurve aus FitBit:

Wir sehen, dass sich die Person lediglich 3,5% im Tiefschlaf befand, was ein sehr niedriger Wert ist. Am nächsten Tag, wenn man mit dem Roboter spricht, könnte ein Dialog in Alexa starten wie beispielsweise:

Alexa: Dein Schlaf-Verhalten zeigt, dass du in letzter Zeit wenig bzw. schlecht geschlafen hast. Kann es sein, dass du dich müde fühlst?

NutzerIn: Ja …

Alexa kann nun weiterführende Fragen stellen und am Schluss einen personalisierten Tipp geben oder verwandte Artikel im Internet automatisch zum Lesen finden. Alexa könnte auch Alexa-Skills wie „Einschlafgeräusche“ zum Ausprobieren anbieten oder vorschlagen man solle Probieren vor dem Einschlafen ein heißes Bad zu nehmen. Anhand der Fitbit-Aufzeichnungen ist es leicht zu verfolgen, ob angebotene Tipps bei dem/der NutzerIn angeschlagen haben oder nicht. Aus diesen neuen Informationen kann man aufbauen. Man könnte diese Informationen auch um die Emotionserkennung ergänzen. Falls über die Ekman-Methode Schlafmangel mit der Emotion „Ärger/Wut“ in Verbindung gebracht werden kann (also eine Person auf chronischen Schlafmangel regelmäßig mit Wut reagiert), so kann auch dieses Wissen in die Personalisierung mit einfließen.

Dieser Gedanke lässt sich auf viele relevante Themen übertragen. Der angebotene Dialog zum Thema „Sport und Bewegung“ könnte z.B. durch gescheiterte Trainingsversuche oder bei Erkennen von typischen Sportvermeidungs-Strategien ausgelöst werden und dabei nach den Gründen für die mangelnde Bewegung fragen. Gerade Menschen mit chronischen Erkrankungen wie beispielsweise Diabetes brauchen regelmäßige Bewegung. Ein Dialog könnte wie folgt starten:

Alexa: Dir machen Sport und Bewegung Probleme? Schau mal, ob dir eines von diesen Problemen bekannt vorkommt.

- Antwort 1 – Ich mache zu wenig Bewegung / Sport

- Antwort 2 – Ich mache Bewegung/Sport so wie ich es soll, bin aber nicht glücklich damit

- Antwort 3 – Ich mache zu viel Bewegung / Sport

Alexa: Könnte eines der folgenden Themen der Grund für zu wenig Bewegung / Sport sein?

- Antwort 1 – Ich möchte nicht, dass andere über meinen Diabetes Bescheid wissen

- Antwort 2 – Ich habe Angst vor einer Unterzuckerung

Weitere Fragen…

Gut zu wissen. Viele Menschen mit Diabetes machen sich Sorgen über einen niedrigen Blutzuckerspiegel (Hypoglykämie oder “Hypo’s”). Wenn du mehr darüber erfahren willst, dann sage „Thema merken“

Das gemerkte Thema kann dann gespeichert werden und es können verschiedene Artikel als Hilfestellungen zum Problem-Thema gelesen werden:

Fokusgruppen, Feedback und Anwendung im echten Leben

Die hier gezeigten Ideen und Technologien entstammen dem Projekt „RoboGen“, welches sich für den Einsatz der hier vorgestellten Roboter Q.Bo One, Anki Vector und Echo Show 2 entschieden hat. „RoboGen“ verwendet darüber hinaus eine FitBit Charge 2 um biometrische Daten messen zu können. Das Projekt möchte unter Zuhilfenahme von Fokusgruppentests iterativ Konzepte erarbeitet, um SeniorInnen mit 50+ oder Menschen mit chronischen Erkrankungen zu unterstützen. Die gezeigten Dialoge werden im Kontext von Erkrankungen wie Diabetes oder Bluthochdruck angeboten, aber beschäftigen sich auch mit Themen wie Stress, Einsamkeit und gesundem Leben im Alter. Die Generation der Baby-Boomer geht bald in Pension, sieht man sich die Alterspyramide an, erkennt man leicht die große Relevanz des Themas.